Google Search Console - Grauen Index fixen - WordPress robots.txt

Möchtest du mehr zum Thema Indexierung erfahren?

Du arbeitest hart an deiner Website, schreibst tolle Inhalte und optimierst unter Beachtung aller relevanten SEO-Prinzipien für die Suchmaschinen. Trotzdem rankst du nicht so gut wie erhofft? Die Ursache könnte im „Grauen Index“ der Google Search Console liegen. Lass uns gemeinsam die Indexierung optimieren, indem du deinen Index aufräumst!

Um den Grauen Index in der Google Search Console für WordPress zu fixen, passe deine robots.txt an. Diese Anpassung hilft, unnötige Indexierungen zu verhindern und optimiert die Sichtbarkeit deiner Website in Suchergebnissen.

In diesem Artikel zeige ich dir, wie du mit ein paar einfachen Schritten den grauen Index in der Google Search Console korrigieren kannst. Nutze meine optimierte robots.txt Datei, um viele Probleme mit einem Schlag zu erledigen.

Was ist der „Graue Index“?

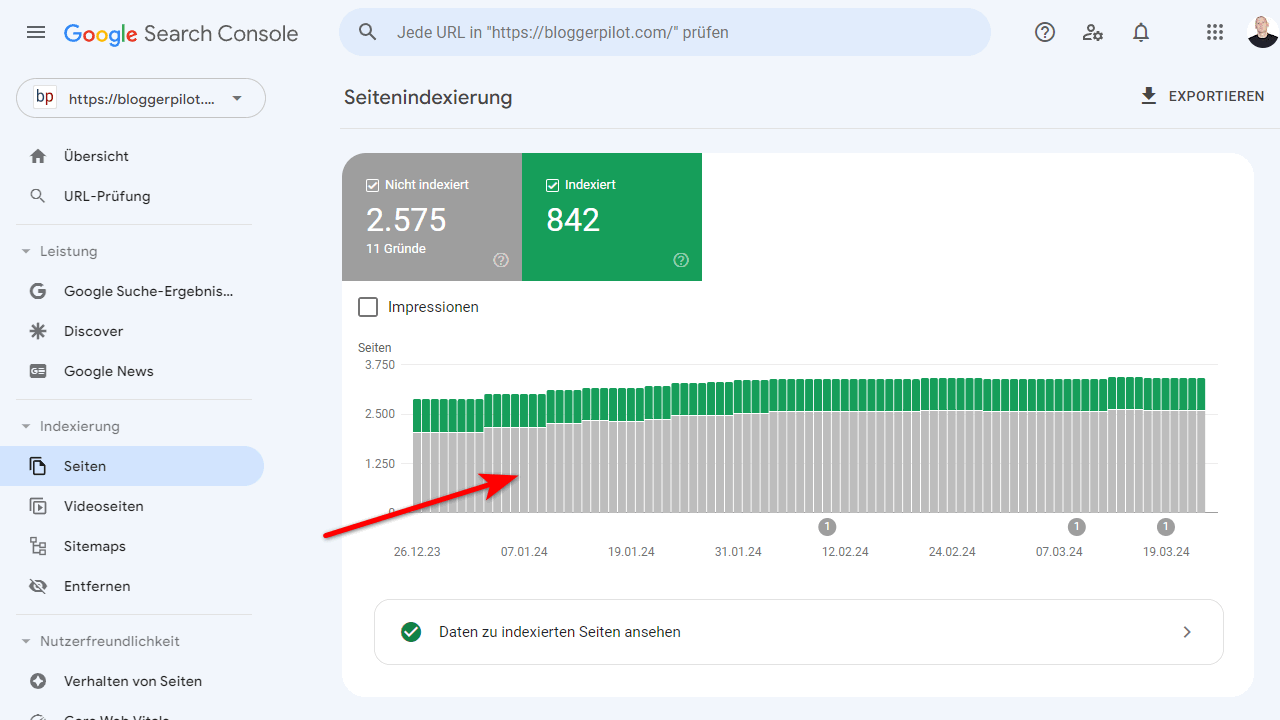

In der Search Console kannst du unter Indizierung > Seiten sehen, welche deiner Webseiten von Google indiziert wurden. Die indizierten Seiten sind in Grün aufgeführt. Aber es gibt dort auch einen grauen Bereich: Das ist der „Graue Index“ mit allen Seiten, die Google zwar gecrawlt hat, jedoch nicht in den Suchergebnissen anzeigt.

Warum indiziert Google manche Seiten nicht? Es kann viele Gründe dafür geben – technische Fehler, Content-Duplikate, falsche Tags und mehr. Ohne Indizierung hast du aber keine Chance auf Rankings und SEO-Traffic. Deshalb ist es essenziell, dass du den Grauen Index regelmäßig überprüfst und bereinigst.

Ich gebe zu, am Anfang habe ich den Grauen Index auch nicht beachtet. Als ich dann aber Kundenwebsites mit hunderten oder gar tausenden nicht indizierten URLs sah, wurde mir klar, wie wichtig diese Pflege ist. Gerade bei großen Seiten können die Traffic-Verluste durch Nicht-Indizierungen sonst riesig sein.

Also ran an den Grauen Index! Ich zeige dir jetzt die gängigsten Probleme und wie du sie beheben kannst.

Eine saubere robots.txt verhindert unnötige Indizierung

Wenn du nicht den ganzen Artikel lesen möchtest und gleich eine Lösung suchst, habe ich mit der robots.txt angefangen, die du kopieren und bei dir einsetzen kannst.

Ein guter Anfang ist, in deiner robots.txt Datei festzulegen, welche Bereiche deiner Website gecrawlt werden sollen. Hier ist meine Empfehlung für eine WordPress-Standardinstallation:

User-agent: *

Disallow: /cgi-bin/

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-login.php

Disallow: /wp-content/plugins/

Disallow: /wp-content/cache/

Disallow: /wp-content/themes/

Disallow: */seite/

Disallow: */page/

Disallow: /*?

Disallow: /?s=

Allow: /wp-admin/admin-ajax.php

Sitemap: https://deine-domain.com/sitemap.xml

Mit den Disallow-Regeln schließt du alle System- und Plugin-Verzeichnisse aus, die für den Nutzer irrelevant sind. Außerdem blockierst du URLs mit Fragezeichen-Parameter und die Suchseite. Die Allow-Regel ist wichtig, damit WordPress-Ajax-Funktionen weiterhin erreichbar sind.

Gib am Ende auch die URL deiner XML-Sitemap an, damit Google sie leicht findet.

So beschränkst du den Crawlbereich schon mal auf das Nötigste und verhinderst unnötige Indizierungen.

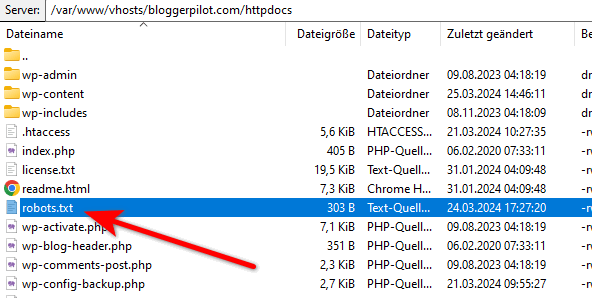

Die robots.txt-Datei kopierst du in das Root-Verzeichnis deiner WordPress-Installation. Also dahin, wo auch die index.php und das Verzeichnis wp-content liegt. Lediglich in der letzten Zeile musst du „deine-domain.com“ mit deiner tatsächlichen Domain ersetzten.

Pagination clever managen

Ein häufiges Indizierungs-Problem sind Paginierungen oder Seitennummerierungen von Kategorien, Archiven oder Suchergebnissen. Google versteht nicht immer, dass es sich um quasi-duplizierte Inhalte handelt.

Nimm dir als Beispiel eine Kategorie-Übersicht mit 200 Artikeln auf 20 Unterseiten. Potenziell könnte Google also 20 ähnliche Seiten bei den Rankings berücksichtigen. Meist ist das nicht erwünscht, da diese Unterseiten wenig inhaltlichen Mehrwert bieten.

Wie also verhindern, dass Google alle Unterstücke indiziert? Es gibt drei gängige Lösungen:

robots.txt – Alle Paginationen ausschließen

Möchtest du kein Plugin nutzen, kannst du die Indexierung über deine robots.txt verbieten. Der Code dafür befindet sich schon in meiner perfekten robots.txt für WordPress weiter oben.

Hier noch mal die gesonderten Zeilen:

Disallow: */seite/

Disallow: */page/Es werden also alle URLs mit „/seite/“ ausgeschlossen. Darunter noch die Variante auf Englisch.

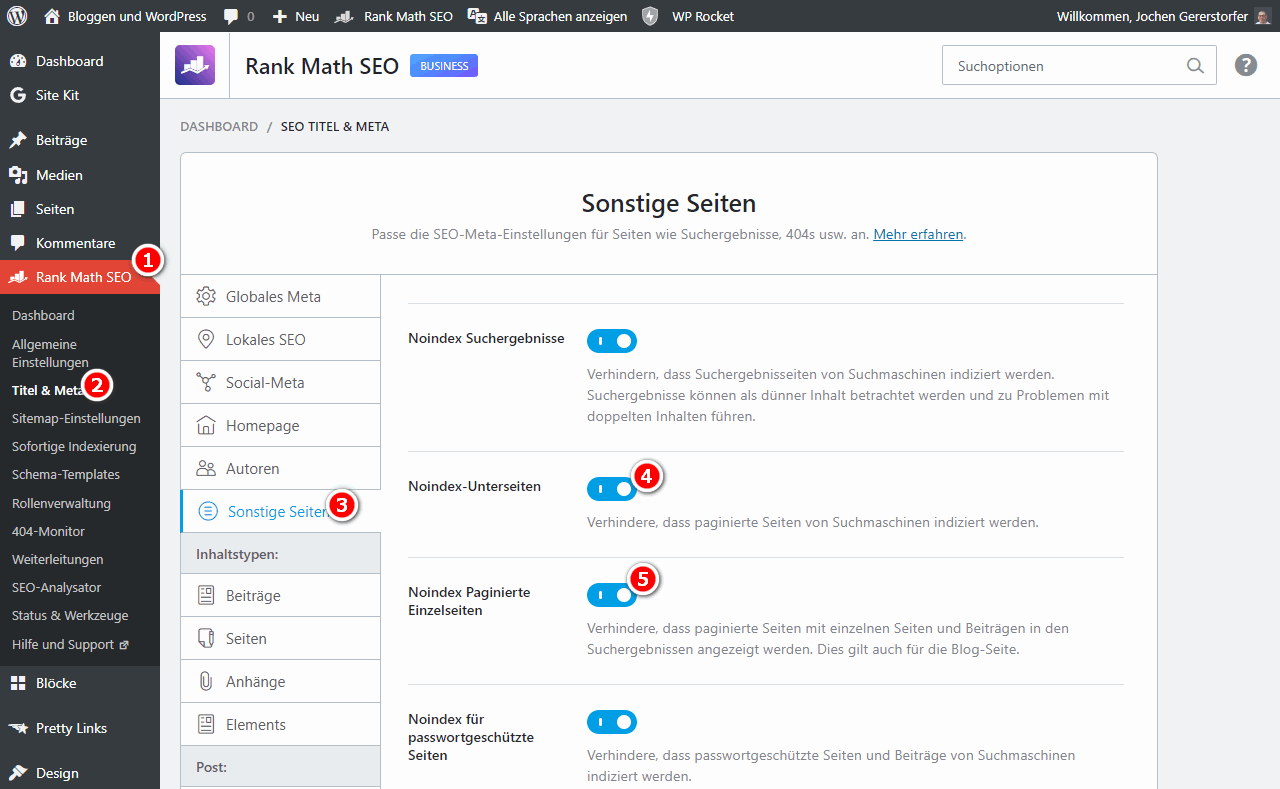

Rank Math SEO Plugin

In Rank Math sind die Einstellungen für die Indexierung der Unterseiten unter „Titel & Meta“ > „Sonstige Seiten“ zu finden. Mit zwei Klicks hast du das Problem gelöst.

Warum ist eine solche Pagination-Optimierung wichtig? Ich habe schon Websites gesehen, auf denen Google Tausende dieser quasi-identischen Unterseiten indiziert hat. Nicht nur eine verfügbare Crawl-Budget-Verschwendung, das reduziert auch den Linkflow und die Sichtbarkeit der eigentlichen Inhaltsseiten.

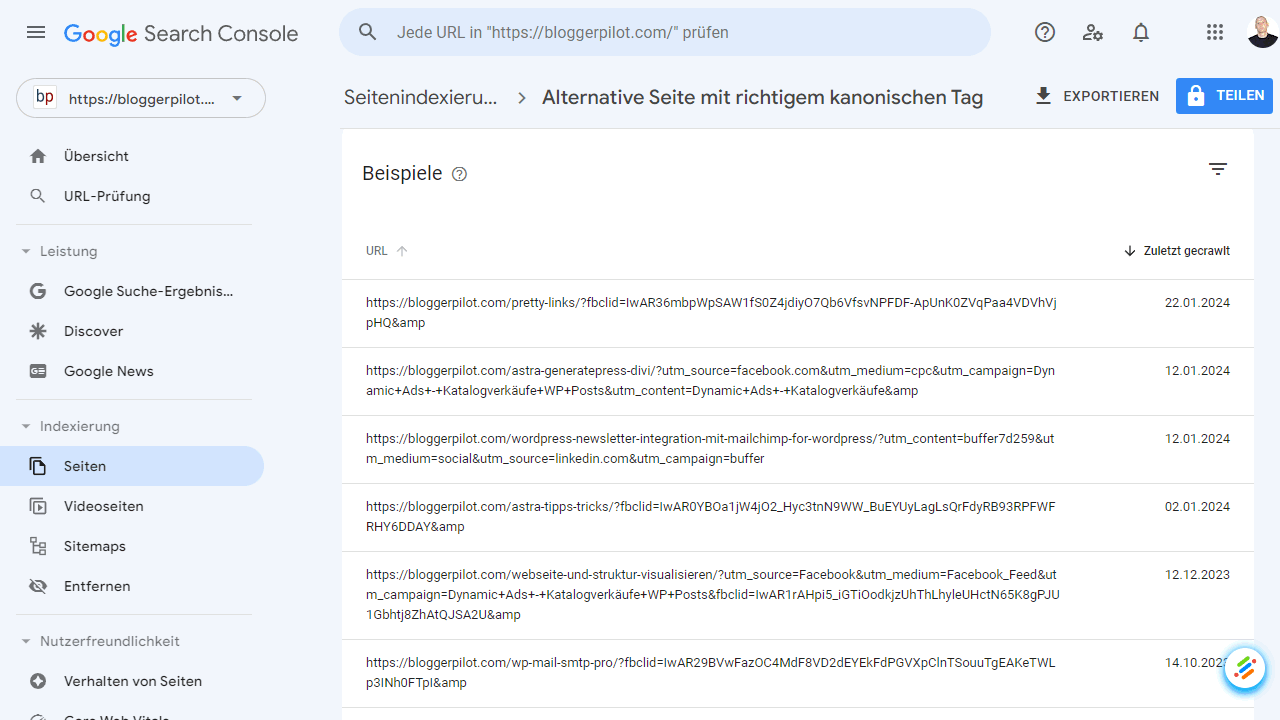

Canonical Tags, Parameter URLs und Content Duplikate ausbessern

Die Probleme mit Canonicals sollte Google alleine lösen können. Bei mir handelt es sich ausschließlich um URLs mit Parametern:

- ?amp

- ?fbclid

- ?utm_source

Dafür habe ich die folgenden zwei Anweisungen in der robots.txt:

Disallow: /*?

Disallow: /?s=Damit sage ich dem Google-Bot gezielt, indexiere keine URLs mit Parametern. So lösen sich Hunderte Fehler in der Google Search Console ganz von allein.

Schaue dir im Grauen Index an, welche Seiten davon betroffen sind. Google sagt dir dort sogar, für welche andere URL es sich entschieden hat – und die solltest du zum Original machen.

Je nach Häufigkeit und Relevanz des Fehlers gibt es verschiedene Lösungsmöglichkeiten:

Ich hatte mal einen krassen Fall, bei dem Hunderte URLs von einer gespiegelten Server-Subdomain aus ranken statt der eigentlichen Website. So eine Duplicate-Content-Bombe killt natürlich die Rankings. Ein Albtraum! Mit einigen Anpassungen war das Problem aber schnell gelöst.

404, Soft 404, 403 und 401 Fehler aufspüren

Auch Fehlerseiten landen gerne mal im Grauen Index. 404 Fehler treten auf, wenn Seiten nicht mehr existieren. Sie sollten harmlos sein, solange es sich nicht um massenhafte Fehler wichtiger Seiten handelt.

Bei den Soft 404 Fehlern musst du aber aufpassen: Hier werden zwar inhaltslose Seiten mit 200 OK-Status ausgeliefert, statt dem korrekten 404. Das kann Crawlbudget verschwenden und den Index unnötig aufblähen.

401 bedeutet „Unauthorized“, häufig bei Login-Formularen oder Administrationsbereich. Sie sind eigentlich unbedenklich, sollten aber möglichst vermieden werden. Dieses Problem habe ich mit der Direktive Disallow: /wp-login.php gelöst.

403 wird meist auch durch die wp-login.php ausgelöst. Nutze meine robots.txt, um das Problem zu beheben.

Im Grauen Index erkennst du alle diese Fehler-URLs auf einen Blick. Dann ist es an dir, die zugrunde liegenden Ursachen zu finden und zu beheben.

Gerade bei 404-Fehlern scheint Google aktuell ein Problem zu haben. Bei mir werden unzählige 404 angezeigt, von Unterseiten die nie existiert hatten.

500er Serverfehler checken und Server-Logs prüfen

Während die 400er Fehler tendenziell unkritisch sind, musst du 500er Server-Fehler auf jeden Fall genauer untersuchen!

Diese Fehlercodes zeigen an, dass die Website Probleme hat und Inhalte nicht korrekt ausliefern kann. Das führt nicht nur zu schlechter Indexierung, sondern beeinträchtigt natürlich auch die Nutzererfahrung enorm.

Prüfe daher regelmäßig, ob Fehler dieser Art im Grauen Index erscheinen. Parallel solltest du die Server-Logs checken, um die genauen Fehlerursachen wie Software-Konflikte, Memory-Leaks etc. zu finden.

Vielfach hat der Server im Moment der Auslieferung nicht genug Ressourcen und läuft deshalb in einen Fehler. Hier sind die drei häufigsten Problemlösungsansätze:

- Du benötigst ein größeres Hostingpaket

- Erhöhe das PHP memory_limit (kontaktiere deinen Provider)

- Nutze ein Caching-Plugin

Weißt du über den Google Search Leak Bescheid?

Fazit: Regelmäßige Index-Pflege für besseres SEO

Als ich angefangen habe, den Grauen Index meiner Websites regelmäßig zu prüfen, haben sich mir viele neue Optimierungs-Möglichkeiten eröffnet. Wer seinen Index sauber hält, indem er unerwünschte Indizierungen verhindert und Fehler beseitigt, erreicht:

- Fokussierte Crawls ohne unnötige Ressourcen-Verschwendung

- Optimaler Linkflow auf die wichtigen Inhaltsseiten

- Weniger Content-Kannibalisierung und Duplicate-Content-Probleme

- Bessere Sichtbarkeit und Rankings in den Suchergebnissen

Mit anderen Worten: Ein aufgeräumter Grauer Index ist der Schlüssel zu performantem SEO! Ich empfehle dir daher, wöchentlich deine Indexierung in der Search Console zu beobachten.

Je häufiger du den Status quo überprüfst, desto schneller erkennst und behebst du Probleme. Optimiere deine Seitenindexierung systematisch und konsequent – und genieße die Früchte deiner Arbeit in Form von mehr qualifizierten Besuchern!

👉 So geht es weiter

- Implementiere die empfohlenen Änderungen an deiner robots.txt und beobachte die Verbesserungen in der Google Search Console.

- Erweitere dein SEO-Wissen mit unserem Leitfaden zu SEO Faktoren, um noch tiefer in die Materie einzusteigen.

- Erfahre mehr über effektives Content-Marketing und wie du Artikel schreibst, die ranken, indem du unseren Blogpost zum Thema KI-Artikel schreiben liest.

Offenlegung Werbelinks: Mit einem Stern (*) gekennzeichnete Links und Buttons sind sogenannte Affiliate-Links. BloggerPilot bekommt bei einem Kauf eine Provision, die sich jedoch nicht auf den Endpreis auswirkt. Es ist uns wichtig zu betonen, dass dies keinen Einfluss auf unsere Bewertung oder Meinung hat.

Danke für den Beitrag.

Werde mir das in den nächsten Tagen mal genauer anschauen.